Über diesen Beitrag

KI-Halluzinationen stellen ein zunehmendes Problem in einer Welt dar, die immer stärker auf künstliche Intelligenz vertraut. Sie sind wie digitale Fata Morganas – sie sehen echt aus, doch der Schein trügt. Stellen Sie sich vor, Sie verlassen sich auf ein System, das Ihnen falsche Informationen liefert – es ist, als würde man einem vertrauten Freund zuhören, nur um später festzustellen, dass seine Erzählungen reine Fantasie waren. Diese beunruhigenden Halluzinationen, in denen Modelle wie ChatGPT ungenaue oder schlichtweg falsche Fakten generieren, stellen eine ernsthafte Herausforderung dar. Sie werfen drängende Fragen zur Zuverlässigkeit und Integrität generativer Systeme auf, die immer mehr in unser tägliches Leben eingreifen. Inmitten dieser Unsicherheit investieren Technologieriesen wie Google und Microsoft intensiv in die Verbesserung ihrer Sprachmodelle, um diese Trugbild-ähnlichen Fehler zu erkennen und zu verhindern. Doch wie genau entstehen diese KI-Halluzinationen, und welche Schritte können unternommen werden, um die Qualität und Genauigkeit der gelieferten Informationen zu gewährleisten?

Inhaltsverzeichnis

Was sind KI-Halluzinationen?

KI-Halluzinationen treten auf, wenn ein KI-System, insbesondere ein generatives Modell wie GPT, falsche oder irreführende Informationen erstellt, die keinen Bezug zur Realität haben. Diese „Halluzinationen“ entstehen oft nicht durch mangelndes Wissen, sondern durch die Art und Weise, wie das Modell auf Mustern in großen Datenmengen basiert, um Antworten zu generieren. Statt eine Frage korrekt zu beantworten, „halluziniert“ das Modell und erfindet Fakten, Orte, Ereignisse oder Zusammenhänge, die es so nie gegeben hat. Dies kann von kleinen Ungenauigkeiten bis hin zu komplett erfundenen Informationen reichen.

Solche Fehler stellen in der Praxis ein erhebliches Problem dar, da sie das Vertrauen in die Zuverlässigkeit von KI-Systemen untergraben. In sensiblen Bereichen wie Medizin, Recht oder Forschung können KI-Halluzinationen gravierende Auswirkungen haben, da falsche Informationen möglicherweise schwerwiegende Konsequenzen nach sich ziehen. Das Verstehen, wie und warum diese Halluzinationen entstehen, ist daher der Schlüssel, um die Qualität und Genauigkeit der von KI generierten Inhalte zu verbessern.

Chatbot-Planung leicht gemacht mit unserer interaktiven Schritt-für-Schritt-Anleitung

AI-Agent Guide PDF Download

- E-Mail Adresse eingeben und absenden

- PDF direkt per E-Mail zum Download erhalten

Warum kommt es zu KI-Halluzinationen?

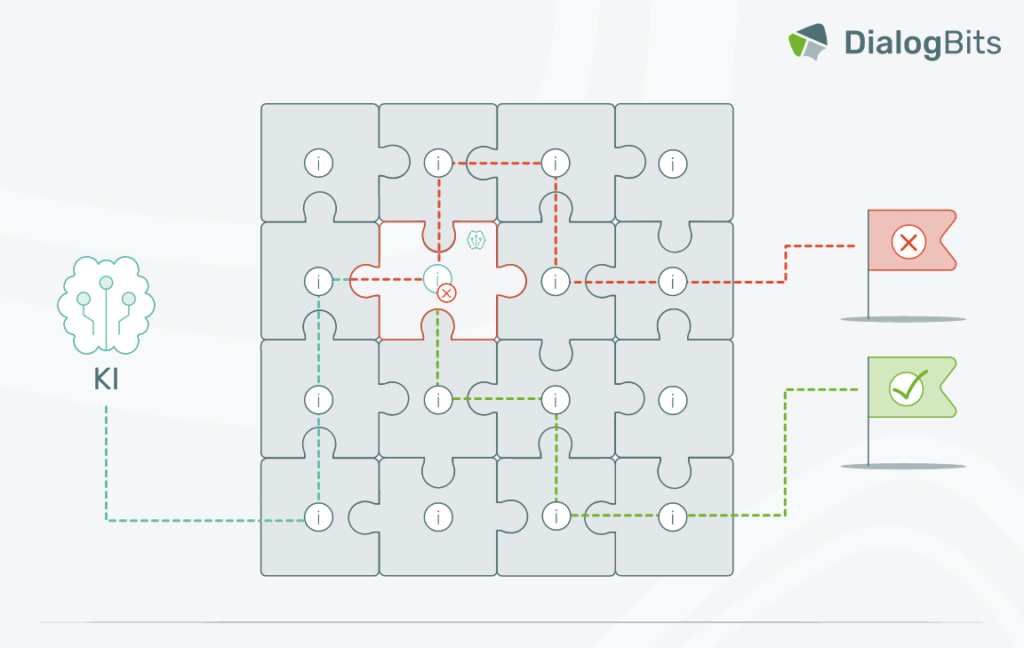

KI-Halluzinationen entstehen aufgrund der Art und Weise, wie künstliche Intelligenz trainiert wird. Generative Modelle wie GPT basieren auf riesigen Datenmengen und lernen durch die Erkennung von Mustern und statistischen Zusammenhängen. Allerdings verstehen diese Systeme nicht wirklich den Kontext oder die Bedeutung der Informationen, die sie verarbeiten. Sie sind darauf ausgelegt, plausible Antworten auf der Grundlage ihrer Trainingsdaten zu generieren, nicht jedoch auf eine tatsächliche „Wahrheit“ zurückzugreifen.

Eine der Hauptursachen für Halluzinationen ist, dass das Modell auf unvollständige oder fehlerhafte Daten zurückgreift. Wenn das Modell keine passenden Informationen findet, „halluziniert“ es eine Antwort, die für den Nutzer zwar glaubhaft klingen mag, jedoch keinerlei Bezug zur Realität hat. Zudem werden KI-Modelle oft so trainiert, dass sie auf jede Anfrage eine Antwort geben – selbst wenn keine exakte Information vorhanden ist. Dies verstärkt die Wahrscheinlichkeit, dass das Modell in Fällen, wo Daten fehlen, eine falsche oder erfundene Information liefert.

Ein weiterer Faktor ist die Komplexität der generativen Prozesse. KI-Modelle folgen komplexen Algorithmen und statistischen Modellen, die darauf optimiert sind, kohärente und flüssige Texte zu produzieren. Dabei kann es jedoch vorkommen, dass das Modell zufällige Fakten oder Verknüpfungen erstellt, die in der Realität nicht existieren, da es stets bemüht ist, die nächste passende Wortwahl vorherzusagen – manchmal auf Kosten der Genauigkeit.

Zusammengefasst entstehen KI-Halluzinationen durch die Mischung aus statistischer Textgenerierung, unvollständigen Daten und der fehlenden Fähigkeit der KI, echte Bedeutungen und Fakten zu verstehen.

Lösungsansätze zur Minimierung von KI-Halluzinationen

Es gibt verschiedene Ansätze, um das Risiko von Halluzinationen zu minimieren, die darauf abzielen, die Genauigkeit und Zuverlässigkeit der generierten Inhalte zu verbessern. Diese Ansätze kombinieren Datenqualität, Modellarchitektur und externe Überprüfungsmechanismen, um faktisch korrekte und relevante Informationen zu gewährleisten.

Ein Überblick der gängigsten Lösungsansätze:

KI-Halluzinationen in Chatbots: So begegnet DialogBits den Herausforderungen

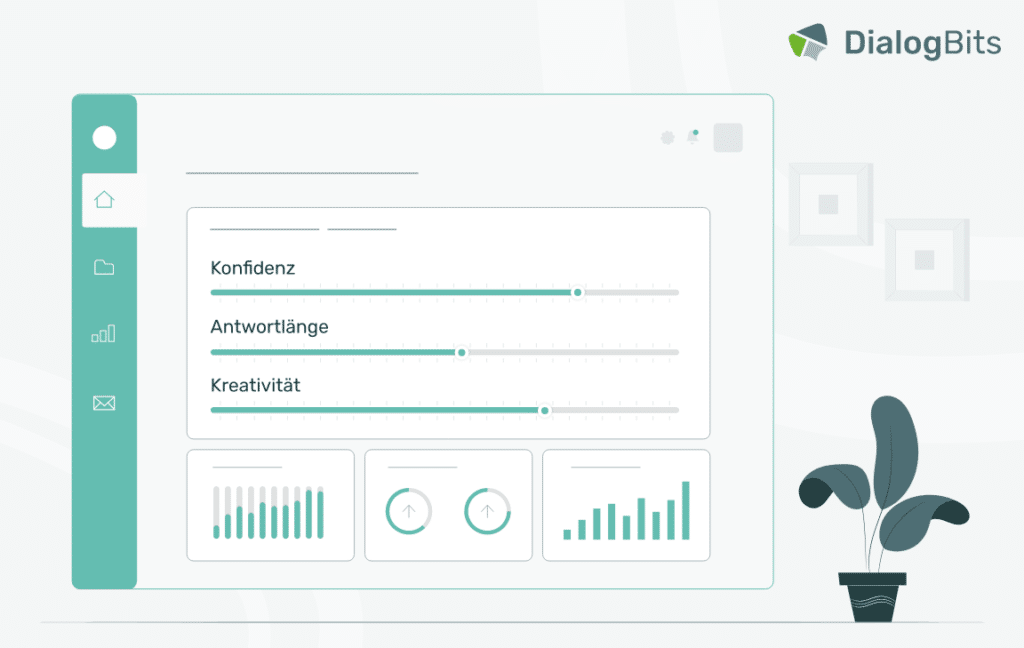

Um die Herausforderungen bei der Nutzung Generativer KI in unseren Chatbots zu bewältigen, stellt DialogBits eine Reihe von Parametern bereit, die eine gezielte Steuerung der Modellausgaben ermöglichen.

So gewährleisten wir, dass die Nutzer unserer Kunden stets präzise und korrekte Antworten erhalten, Halluzinationen auf ein Minimum reduziert werden und die Antwortqualität konstant auf höchstem Niveau bleibt.

Fazit: Der Weg zu verlässlicherer KI ohne Halluzinationen

KI-Halluzinationen sind ein ernstes Problem, das die Zuverlässigkeit und das Vertrauen in generative KI-Modelle erheblich beeinträchtigen kann. Sie entstehen vor allem durch die statistische Natur der Textgenerierung und den Mangel an echtem Verständnis für die Bedeutung von Informationen. Doch es gibt Hoffnung: Mit gezielten Maßnahmen wie der Optimierung von Trainingsdaten, der Integration externer Wissensquellen und dem Einsatz von Verstärkungslernen mit menschlichem Feedback lässt sich das Risiko von Halluzinationen deutlich verringern. Auch Mechanismen wie Selbstüberwachung und Konfidenzbewertungen helfen dabei, die Qualität und Präzision der KI-Ausgaben zu verbessern. Der Einsatz dieser Ansätze wird entscheidend sein, um sicherzustellen, dass generative KI nicht nur innovativ, sondern auch verlässlich bleibt.

Testen Sie das Potenzial unserer generativen KI-Chatbots selbst und heben Sie Ihre Unternehmenskommunikation auf ein neues Level. Persönliche Beratung, Plattform-Tour und kostenloser Testzugang inklusive.